オープンで信頼あるAI社会の実現のために ~東京大学とNECが共に考えたAI倫理~

社会での活用が進むAI。その価値を享受するためには、適切にAIリスクを制御しなければならないと考えられており、世界のさまざまな国や地域でAI倫理、法制度、社会的受容性が議論されている。国内では、東京大学とNECが共同研究に取り組んだ。文理、産学の異なる視点を持ち寄った共同研究は、どのような成果につながったのか。

提供者と受容者の視点でAI倫理を確認

──東京大学とNECは、2016年に「フューチャーAI研究・教育戦略パートナーシップ協定」を締結し、以降、AIに関する共同研究に取り組んできました。取り組みの背景についてお聞かせください。

菅原:現在のAI市場の盛り上がりを第3次AIブームと呼びますが、第2次、第1次ブームのころのAIに比べるとはるかに複雑で高度なことができるようになっており、社会へのインパクトも絶大です。それゆえ、どのように使うか、どのように社会に適用するかが非常に重要な課題です。使い方を間違えれば、学習データに潜んでいたバイアスで差別を再生成したり、本来、人々を幸せにするためのものなのに不快な思いをさせてしまったり、目的とは反対に作用してしまう可能性があります。そこで、AIの社会的受容に向けた文理融合研究として、東京大学様とNECでAIの倫理・法制度および社会的受容性についての共同研究を開始しました。

NEC コーポレート 経営企画部門 マネージングディレクター(現在)

菅原 弘人

──具体的には、どのような研究を行ったのでしょうか。

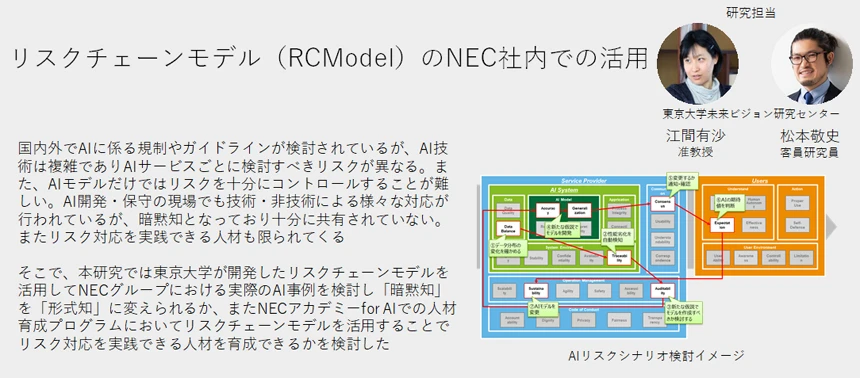

菅原:NECのようなAIやAIサービスの提供者側、そして、企業や生活者といった受容者側の2つの視点で研究に取り組みました。具体的には、提供者側の視点で取り組んだのが「リスクチェーンモデル(RCModel)のNEC社内での活用」「責任分担に関する研究」「国際的なAI倫理の実践と調査とネットワーキング」の3つ。そして受容者側の視点で取り組んだのが「AIサービスの社会的受容性に関する研究」です。

NECの社内教育でRCModelの有効性を検証

──共同研究「RCModelのNEC社内での活用」についてお聞かせください。

城山氏:AIの価値を社会が享受するには、どのような環境づくりが必要か。私は、そのことに興味があり共同研究に参加しました。

実際、世界のさまざまな国や機関でAIの適正な利用を促すためのルールや仕組みづくりが進んでいます。しかし、人事採用やローン審査に利用する際は「公平性」、生体情報を扱うなら「プライバシー」など、リスクと一言でいってもAIサービスごとに注視すべき重要リスクは異なります。そこで東京大学は、そのAIサービスの重要リスクは何か、誰がリスクに責任を持ち、どうコントロールするかを具体的局面に即して考えるためのフレームワークとして「リスクチェーンモデル(RCModel)」を開発しました。

私たちが行った「リスクチェーンモデル(RCModel)のNEC社内での活用」という共同研究では、RCModelを実際にNECの教育プログラム「NECアカデミー for AI」に取り込み、NECの社内教育に活用しました。多くのNEC社員の目でRCModelを確かめ、有効性を評価したり、課題を見つけたり、今後、活用していく上で非常に貴重な機会になったと考えています。

たとえば、RCModelはAIサービスの開発プロセスで、そのサービスのリスクを把握し、対処するために使うこともできますが、今回、NECと取り組んだように社員教育に利用すれば、企画、開発、営業など、幅広く多様な担当者のAIリスク対応力を底上げすることができます。そうすれば、ビジネスのあらゆる場面で常に多角的にAIのリスクを考え、対処できる組織になれるはずです。

この気付きを受け、次はどのようなメカニズムで教育を実施すると効果的かなど、RCModelの教育プログラム化に向けた検証などに取り組みたいと考えています。

未来ビジョン研究センター センター長(当時)

公共政策大学院 教授

法学政治学研究科 教授

未来ビジョン研究センター 教授

城山 英明氏

菅原:NEC社内教育の成果を受けて、お客様の中にもRCModelによる社内教育に取り組む企業が出ています。サービス開発の初期段階でメリット、デメリットに気付けるようになるはずと大きな期待が寄せられています。

AIは国や法律によって統治するべきか

──「責任分担に関する研究」についてお聞かせください。

宍戸氏:私の専門は法律です。既存の法律は人の行為を規律するものですが、クルマの自動運転のように自動化を担うAIが登場した現在、その行為をどう規律するかは法学の重要なテーマです。

今回、NECと共に行った「責任分担に関する研究」という共同研究では、AIやAIサービスを提供する事業者、それを利用するユーザや生活者、誰が、どのような責任を負うのが適切かを検討すべく、フィールドワークによるヒアリングやアンケートを実施しました。

結果、多くの生活者はAIが生活をよくしてくれると期待していますが、その前提として国にしっかりとAIやAIサービスを提供する企業を規制してほしいと考えているようです。ただ、具体的な規制となると、個人情報の保護は多くの人が気にするものの、それ以外には強い要望は上がりませんでした。

場合によっては国家権力並みの力を持つ可能性があるデジタル企業をどう規制するか。統治の主体は国であるべきかどうか、ヨーロッパで議論されている「デジタル立憲主義」の調査も重要な成果です。

大学院法学政治学研究科

教授

宍戸 常寿氏

──「国際的なAI倫理の実践と調査とネットワーキング」とは、どのような研究でしょうか。

城山氏:イギリス、欧米、アフリカ・中東など、世界の各地域でAI倫理がどのようなルールや制度で運用されているかを調査しました。各地域、それぞれ異なる課題意識をもってAI倫理と向き合っていることがわかりました。調査結果は、日本にとって最適なAI倫理の運用を考えていく上で視野を広げる材料となります。

分からなくてもAIは受容できる

──受容者の視点で行った共同研究「AIサービスの社会的受容性に関する研究」では、どのような発見がありましたか。

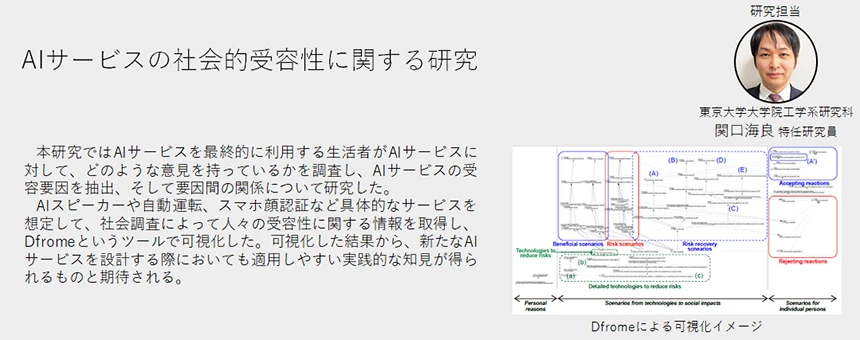

大澤氏:先ほど責任分担に関する研究の中でも受容性に触れましたが、この共同研究は、何がAIの社会的受容性を決めるのかを明らかにするためのものです。

まず多くの人にAIスピーカー、自動運転、顔認証、資産運用ツールなど、さまざまなAIサービスに対する考え方を聞きました。結果、傾向として、自動運転カーのように高額なもの、自身の財産を左右する資産運用ツールのようなAIの購入や利用はハードルが高いようです。まだ「得体が知れない」「大切な意思決定はAIにさせたくない」と考えている人が多いということでしょう。

また、討論によって、その考え方がどう変わっていくのかについても調査しました。そうすると、肯定的な人も、否定的な人も、意外に簡単に意見を変える姿が多く見られました。ある意味「いい加減」と思えるほどです。

これらのことから、生活者のAIは「わからなさ」とも同居していると考えられます。そして、その構造は、そもそも人の社会と同じだとも気付きました。私たちも相手を100%知らなくても、相手の頭の中を見ることはできなくても、他人を信じて仕事を任せたりしています。またバイアスによる差別やプライバシーも、AIを活用する以前から社会にある問題ですから、それが理由でAIを受容できないということはないはずです。どうすればAIを社会に実装できるかではなく、どうすれば社会がAIを実装できるかを考えるべきなのかもしれません。

大学院工学系研究科

システム創成学専攻

博士(工学)

教授

大澤 幸生氏

菅原:世間では「説明性AI」とか「説明可能AI」といわれ、説明できることがAIを受け入れてもらう条件のようにいわれています。もちろん重要な条件の1つですが、私たちはそれだけではないと考えています。NECが目指すのは「説明できるAI」を超えて「信頼できるAI」と表現しています。

文理、産学、複数の視点を持ち寄る意義

──東京大学とNECが共同で研究を行った意義をどのように考えていますか。

宍戸氏:私たちが研究しているのはAIの社会実装ですから、日々、社会課題と向き合い、どのように解決するかを考えているNECと共に研究に取り組めたのは、とても有意義でした。私より若い世代の法学者に向けて、AIと法律という新しい学問の種を巻くことができたことも大きな成果だと感じています。

大澤氏:データ分野においてNECは突出した技術力を持っていると評価していますが、共に共同研究に取り組むと、それだけではないことに気が付きました。技術者、提供者だけでなく受容者、つまり生活者の視点をしっかりと持っている人も多い。AIの社会実装を共に考える上で、これ以上の存在はいないと心強く感じています。

菅原:社会は1つの側面だけではありませんから、私も「文」と「理」、そして「産」と「学」という複数の視点を持ち寄ることができたことを大きな意義だと考えています。

城山氏:さらにNECの中にも、いろいろな人がいる。実に多角的な視点でAI倫理を確認できました。非常に貴重な経験をすることができました。

──NECは「NECグループ AIと人権に関するポリシー」を策定し、グループをあげてAIの課題解決に取り組むことを発表しています。その取り組みに、今回の共同研究はどのような影響がありますか。

島村:NECは社会価値創造を目指す企業ですが、その中でAIによる人権問題を抑止し、コントロールするための指針として「NECグループ AIと人権に関するポリシー」を策定し、専門組織としてデジタルトラスト推進統括部を構えています。

デジタルトラスト推進統括部の重要な役割は、社会でのAI実装やお客様のAI利活用をお手伝いする中で、人権・プライバシー問題を起こさずに価値創出するための仕組みづくりです。そのためにはAIと人権についての理解を深め、社会的受容性なども確認しながら進める必要がありますが、到底NEC単独で行うことはできません。さまざまな立場の人の考えや知見を結集してなしうる取り組みであり、今回、東京大学様と共同研究を行えたことは、その観点でも大きな意味を持っています。

今回、得た知見は自社のインシデント対策のみならず、お客様のAI利用をご支援する中でも効果的なものです。NECのAI利活用を通じてAIの社会的受容性を高めるためにも、積極的に実践に役立てていきたいと考えています。

デジタルトラスト推進統括部長

島村 聡也

──今後の展開をお聞かせください。

菅原:現在、NECはPurpose実現のためのキーワードとして「Truly Open, Truly Trusted-This is NEC.」を掲げています。キーワードに含まれるOpenやTrustedを実践していく上で東京大学様との研究成果は貴重な財産。私たちのビジネスに積極的に取り入れて、AIによる社会価値創造にまい進していきます。