新たな工場「AIファクトリー」へ設備投資する時代に

~NVIDIA GTC 2025から見るAIの未来~

Text:織田浩一

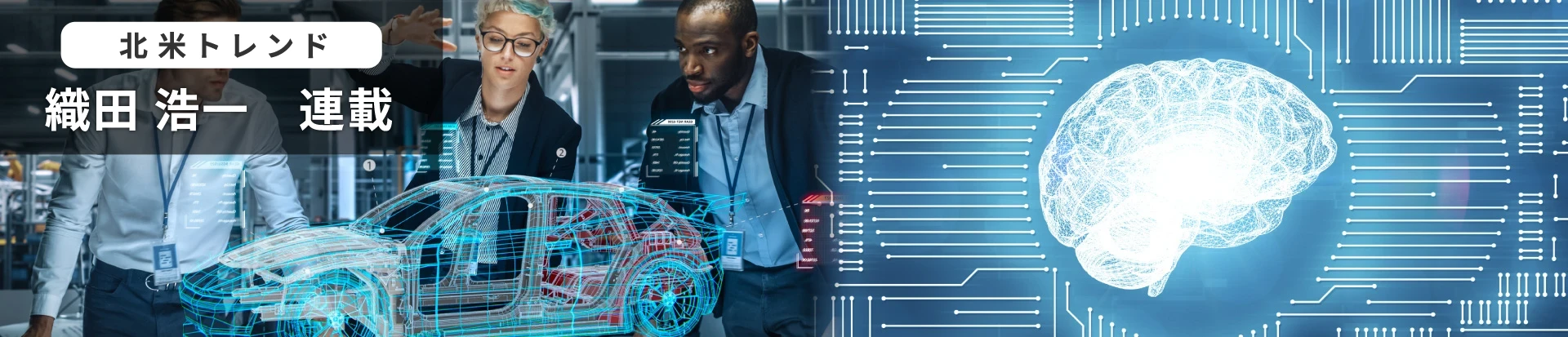

人工知能(AI)の進化が止まらない。大ブームの生成AIにとどまらず、特定の領域に特化せず人間のような汎用的な知能を持つ人工知能「AGI(Artificial General Intelligence」)が2028年までに誕生すると米OpenAIのSam Altman(サム・アルトマン)CEOは予測し、その先には人間の知能をはるかに超えた人工超知能「ASI(Artificial Superintelligence)」の登場が期待されている。3月17日~21日に開かれた米NVIDIAの年次カンファレンス「NVIDIA GTC 2025」でもAI版工場「AIファクトリー」を多くの業種に広げる施策など、AIの加速度的な進化を期待させる議論が数多く見られた。

織田 浩一(おりた こういち)氏

米シアトルを拠点とし、日本の広告・メディア企業、商社、調査会社に向けて、欧米での新広告手法・メディア・小売・AIテクノロジー調査・企業提携コンサルティングサービスを提供。著書には「TVCM崩壊」「リッチコンテンツマーケティングの時代」「次世代広告テクノロジー」など。現在、日本の製造業向けEコマースプラットフォーム提供企業Aperza

AIデータセンターはGAFAを飲み込む規模に

「WOW、HOW、NOW」――。米国のマーケティングやメディアの業界で話題となった、この言葉をご存じだろうか。大手企業における生成AIの導入段階を明瞭に表現

キーノートに登壇したNVIDIAのJensen Huang(ジェンスン・フアン)CEOは、AIコンピューティング需要の急増によりデータセンター投資が加速しているとアピールした。ファン氏は世界で1兆米ドル(約150兆円)規模のデータセンターが、新しいGPUによるアクセラレーテッドコンピューティングのインフラを備えたデータセンター「AIファクトリー」へ変革しつつあると語る。AIファクトリーとは、膨大なデータの取り込みから、学習・分析・推論をして製品やサービスにAIを活用するまでの、AIライフサイクル全般を支援し、データから価値を生み出すために設計された仮想インフラシステムである。2025年におけるMicrosoft、Alphabet、Meta、AmazonのAI設備への資本投資額の合計が3150億ドル(約47兆円)の予定なので、ここ2~3年でGAFAを飲み込むほど大規模な資本がAIファクトリーに投資されると予測する。

その背景として、同氏はAIの適用分野が拡大していることを挙げる。「ソフトウエア開発が、エンジニアがコードを手書きする状態から、AIなど機械学習するソフトウエアがアクセラレーターやGPU上で開発する状態へと移行しつつある。大手企業では、ソフトウエアの未来には資本投資が必要という認識が高まっている」。さらにAIソフトウエアの領域は、ビデオや3Dなどのバーチャルなコンテンツにとどまらず、製造業で生産する製品や医薬品向けの新しいタンパク質や化学物質など、実際に手に取れるリアルなプロダクトにも裾野は広がってきている。

幅広い業界に浸透するAIファクトリー

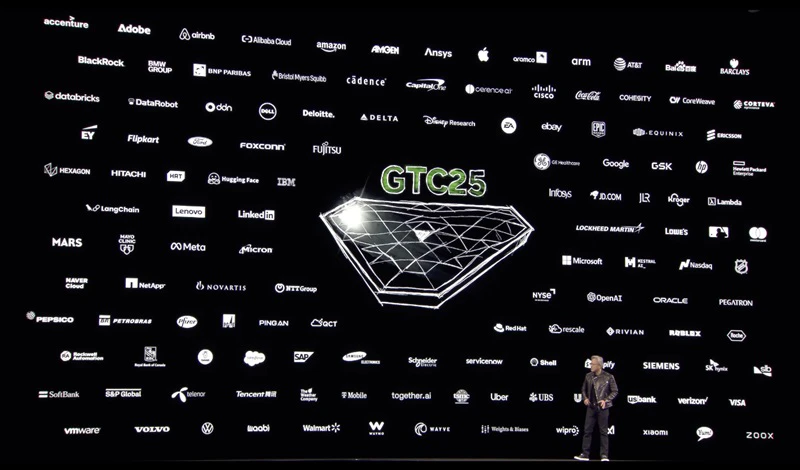

AIファクトリーの概念は、同カンファレンスで発表した自動車メーカーGeneral Motors(GM)とNVIDIAの提携のなかでも示された。今やGMのような製造業でも、現実のファクトリー(工場)に加え、AIファクトリーという新たな工場を必要としている。

GMはAIファクトリーの利用シーンを「工場内」「オフィス」「個々の自動車内」の3つで紹介した。工場内では、AIを活用したリアルタイムトラッキングにより工場や配送ロジスティックスのデジタルツインを構築する。これにより、生産ラインやロジスティックスの構築シミュレーションや課題発見、ダウンタイムの削減、最適化、ロボットプラットフォームの学習、生産などに利用できる。

オフィスでは、従来のオフィス業務の自動化に加え、製品やソフトウエア開発、製品シミュレーション、バーチャルテストでの安全性検証などでの利用を想定している。個々の自動車内では、先進運転支援システム(ADAS)や自動運転、車内体験向上などに利用するとしている。

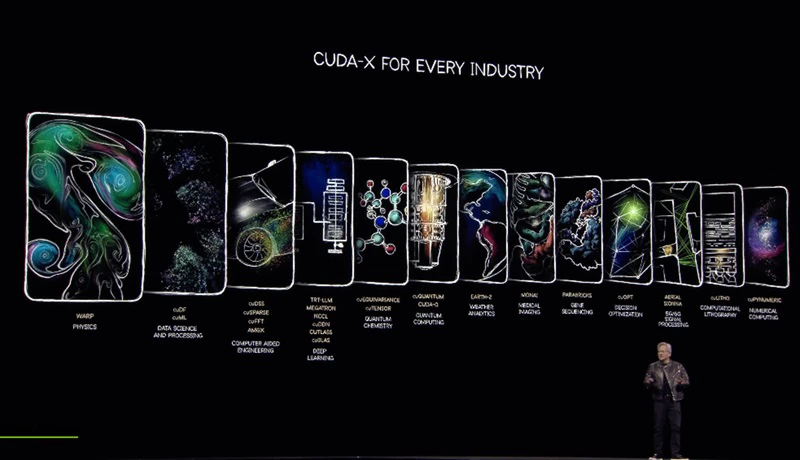

GPUをはじめとするAI半導体で8割を占めるNVIDIAが連携している企業は、GMのような製造業にとどまらない。4万社に上る顧客の業種は、生成AI・AI企業やクラウドサービスプロバイダーから自動車などの製造業、金融、通信、メディア、医療・薬品、小売など多岐に渡っている。NVIDIAは、それぞれの業界に向け機能特化したAIモデルやソフトウエアライブラリ「CUDA-X」を数百種用意し、顧客が自社のデータを使って独自のAIモデルを構築できるようにサポートしている。

ユーザーのAI満足度を左右するスループット

キーノートでは、大手企業がAIファクトリーを実現した際に、顧客や社員、パートナーといったサービス利用者の満足度を上げるには、処理能力を向上させることが重要になるとアピールした。

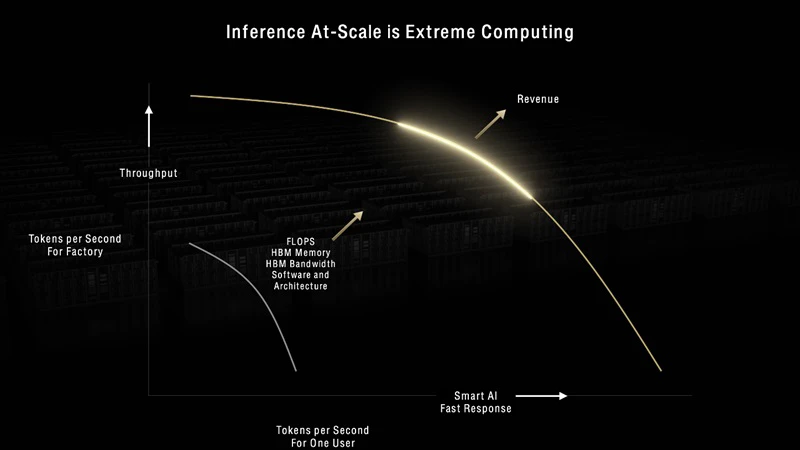

ファン氏は、ユーザーへ提供できる価値とAIサービスの処理能力との相関関係を図で表現した。横軸は1ユーザー・1秒当たりのトークン(AI処理の言語単位。AI処理単位を示すもの)、縦軸はAIファクトリーにおける1秒当たりのトークンのスループット(データ量・転送量)となっており、縦軸と横軸はどちらかを大きくするともう片方が小さくなってしまうトレードオフの関係にあることを示している。

ユーザーへ快適な体験を提供するには、より多くのユーザーリクエストを受け付ける必要がある。だが、特定のAIサービスに人気が出てユーザーが増えると各ユーザーのリクエストを処理する時間、つまり待ち時間が長くなりユーザー体験の満足度は下がってしまう。だが、図の右上方向に向かって処理性能を上げながら多くのリクエストを受け付け、個々のユーザーのリクエストを迅速に処理できるようにすれば、ユーザー体験を上げてサービスの価値向上につながる。それにより、社外向けサービスなら売上の増加に、社内向けならコスト削減に役立つとアピールした。

ユーザーの満足度と処理能力の関係をキーノートで詳細に説明した背景としては、AI半導体のアップデートサイクルを短くしたいNVIDIAの思惑がある。半年ごとに新しいGPUサーバーを提供し、1年後に製品の処理能力が十数倍速い製品を販売する同社にとって、多くの顧客が新製品を購買しAIサービスのスループットを上げ続けることが売上に大きく貢献する。

だが、その流れはクラウドサービスプロバイダーにとっては、必ずしも歓迎するものではない。半年ごとに出る新しいGPUインフラを顧客が求めるならば、古いインフラはより速く償却する必要が出てくるからだ。最近では、その償却費用がAmazon、Microsoft、Google、Metaといったクラウドサービスプロバイダーの利益率に悪影響をもたらすと話題

キーノートの中でフアン氏は、2025年後半に提供するBlackwellは2022年のGPUアーキテクチャーHopperに比べパフォーマンスが68倍高くなり、3年前のHopperにはほとんどAIユースケースがなくなると語った。Amazonではすでに古い資産の償却期間を6年から5年に減らす必要が出ており、このことが同社の利益を7億米ドル(約1053億円)減らすという大きな影響が出始めている。それ以外のビッグテック企業のクラウドサービスではまだ明確な発表はないものの、実際にHopperを使ったクラウドサービスの料金は急激に下落している。

米国AIを揺るがす「Deepseekショック」

NVIDIAのライバルの動きはどうだろう。

従来からの競合であるAMDやIntelなどの半導体メーカーは、学習済みのAIモデルの利用に特化したAI推論チップの開発や利用に注目している。また、GoogleやAmazon、Microsoft、Meta、Appleなどは、独自のAI推論チップを開発し、クラウドプラットフォームやデバイス上でAI利用するために導入を進めている。加えて、独自のAI推論チップを開発しているCerebras、Graphcore、Groqなどのスタートアップ企業もある。

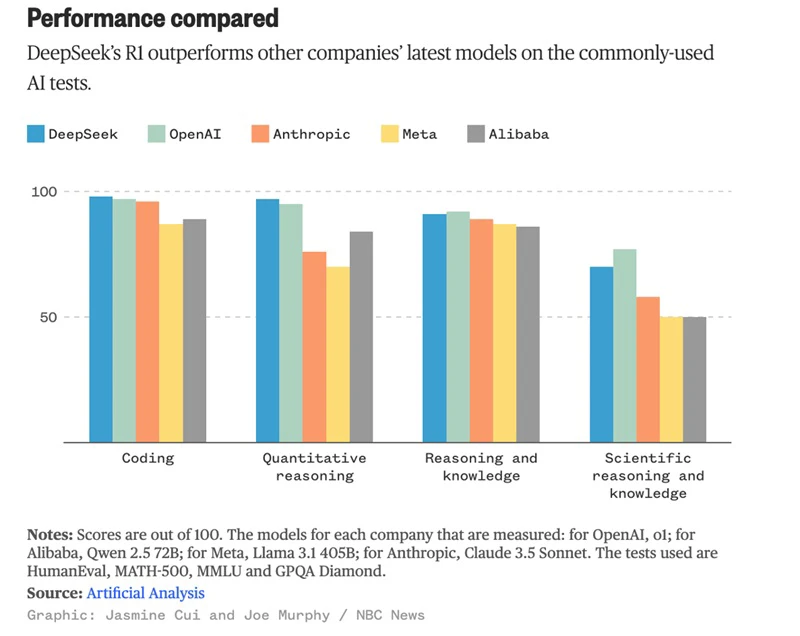

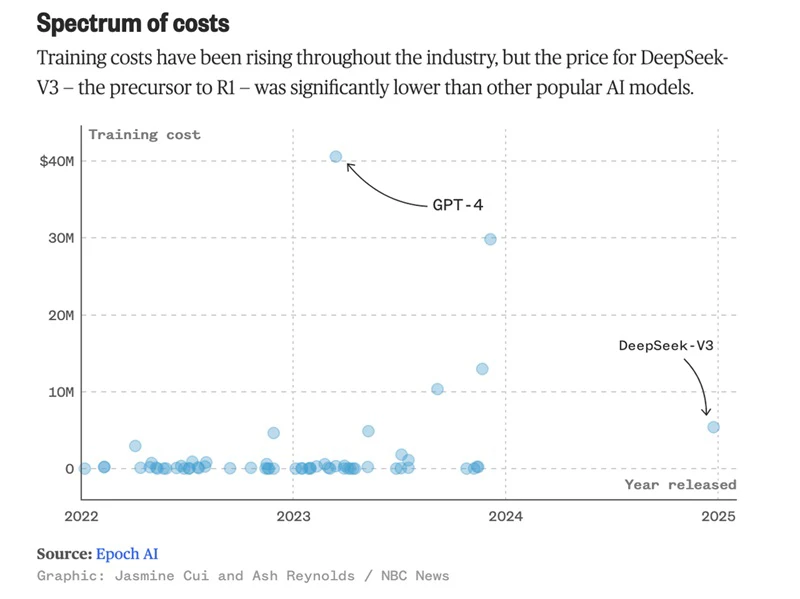

なかでもNVIDIAの業績やアメリカのAI業界に最も影響を与えるのは中国企業の動向だろう。2024年12月に公開されたDeepSeekのAIモデルは、OpenAIのGPT-4やAnthropic Claude 3.5 Sonnetといったアメリカでの大型言語モデルのパフォーマンスを、分野によっては超えたり肉薄したりしている。DeepSeekのAI学習コストが10分の1程度というインパクトもあり、NVIDIAの株式は1日で17%と大幅に下落した。

MicrosoftやGoogle、Amazonは、DeepSeekのAIモデルをそれぞれのクラウドプラットフォームで利用できるようにし、インフラ投資もこれまでと同様に実行する予定である。AI学習コストが大幅に下がることで、無料や低価格でAIモデルを提供できるようになるため、大型言語モデルを提供する企業への価格圧力が高まっている。

中国企業は、AIモデル自体の販売よりも、オープンソースのAIモデルを組み込んだデバイス販売で収益化を目指している。そのため、将来的にアメリカで大型言語モデルを構築する企業にとって価格競争が厳しくなるという考え方

通信向けAIで先行するソフトバンク

NVIDIA GTC 2025では日本企業の登壇も見られた。代表的なものとして、ソフトバンクによるLarge Telecom Model(LTM)の発表を紹介しよう。

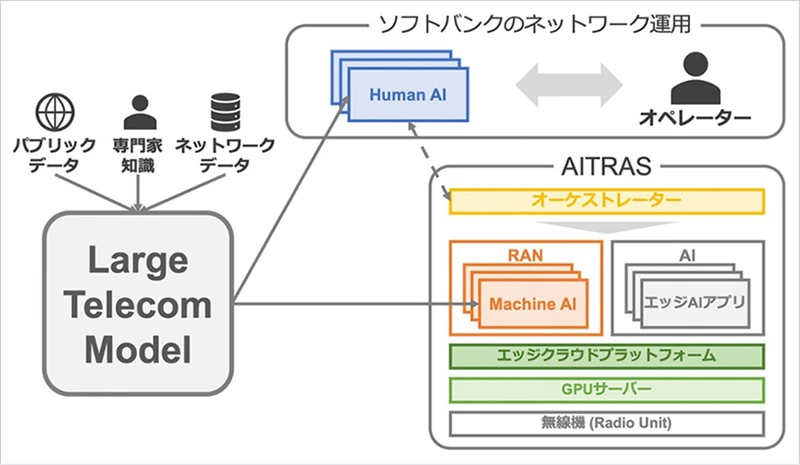

通信会社としてユーザー向けの通信とインテリジェンスへのアクセスを推し進めている同社は、2024年11月にAI -RAN(無線アクセスネットワーク向けのAI)統合ソリューションAITRASを発表している。AITRASでは、通信会社の従来のRANインフラ投資を継続しながらAIインフラを構築すると同時に、AIによるアクセスネットワークの効率化を高めるものである。現在の実証実験では、スループットが約20%向上したという結果

今回新たに発表したLTMは、無線アクセスネットワークを設計、管理、運用するための生成AI言語基盤モデルである。同社のネットワークデータや専門家のノウハウを、基地局の設定や設定変更のために利用でき、ネットワーク最適化AIエージェント開発などにも使えるとしている。将来的には、ほかの通信会社へもサービスとして提供されると考えられる。

NVIDIA GTC 2025で、ソフトバンクの担当者が参加するセッションが3つほどあった。各セッションで欧米の通信会社も参加する中、モデレーターであるNVIDIA担当者が、ソフトバンクの先進的なAI施策が最も進んでいることを解説している様子が印象的だった。NVIDIAとの連携においては、日本企業ではソフトバンクがまずは一歩リードした様相である。

今年のNVIDIA GTCでは、AIファクトリーを含め米国におけるAIの活用が、分野や用途を問わずに拡大していく可能性が高いことを実感できた。日本企業は、自動車や家電といった製造業を含めて、AIを自社の業務にどう活用できるのかを、これまでの常識にとらわれずに改めて考える必要があるだろう。

北米トレンド